تتزايد التحديات الأمنية التي تواجهها المؤسسات مع تزايد اعتمادها على تقنيات الذكاء الاصطناعي، حيث اكتشف باحثون في مجال الأمن السيبراني ثغرة في مساعد الذكاء الاصطناعي (GitLab Duo) قد تمكن المهاجمين من سرقة الشيفرة المصدرية وحقن تعليمات HTML غير موثوقة في ردوده، مما يمكن استغلالها لتوجيه المستخدمين إلى مواقع ضارة.

مقدمة وتحليل شامل

يعتبر GitLab Duo مساعدًا برمجيًا مدعومًا بالذكاء الاصطناعي يمكن المستخدمين من كتابة ومراجعة وتحرير الشيفرة البرمجية، وقد تم تطويره باستخدام نماذج (Claude) من شركة Anthropic. أُطلق هذا النظام لأول مرة في يونيو 2023، ولكن اتضح لاحقًا أنه عرضة لثغرة تعرف بـ “حقن التعليمات غير المباشرة” (Indirect Prompt Injection).

تمكّن هذه الثغرة المهاجمين من سرقة الشيفرات المصدرية من مشاريع خاصة، والتلاعب باقتراحات الشيفرة للمستخدمين الآخرين وحتى استخراج ثغرات (Zero-day) السرية وغير المعلنة. وتعتبر هذه الثغرة جزءًا من فئة من الثغرات الشائعة في الأنظمة القائمة على الذكاء الاصطناعي، حيث يمكن للمهاجمين استغلالها لتوجيه النماذج اللغوية الكبيرة (LLMs) لتوليد استجابات غير مرغوب فيها.

فهم حقن التعليمات غير المباشرة

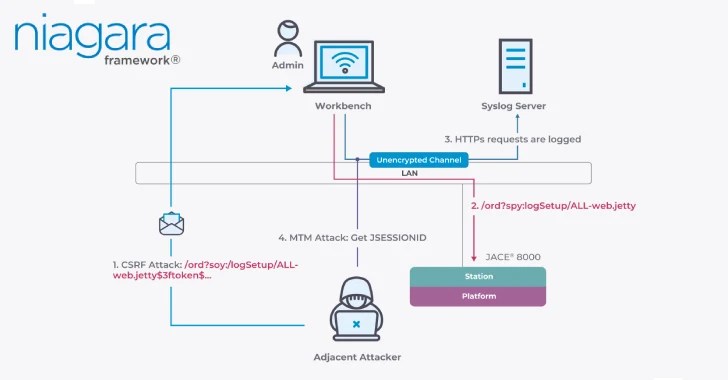

تعتبر “حقن التعليمات غير المباشرة” أكثر تعقيدًا من أشكال الحقن المباشرة، إذ يتم تضمين التعليمات الضارة داخل سياق آخر، مثل مستند أو صفحة ويب، التي يعالجها النموذج. وقد أظهرت دراسات حديثة أن النماذج اللغوية الكبيرة عرضة لهجمات “جلبريك” (Jailbreak) التي تمكن من خداع روبوتات الدردشة المدعومة بالذكاء الاصطناعي لتوليد معلومات ضارة وغير قانونية.

التأثيرات والآثار الأمنية

بالنسبة للمؤسسات، يعني ذلك أن المعلومات الخاصة مثل القواعد الداخلية والمعايير والوظائف يمكن أن تتسرب، مما يتيح للمهاجمين استغلال نقاط الضعف في النظام، ويؤدي إلى خروقات البيانات والكشف عن الأسرار التجارية وانتهاكات اللوائح.

التحديات والتوجهات المستقبلية

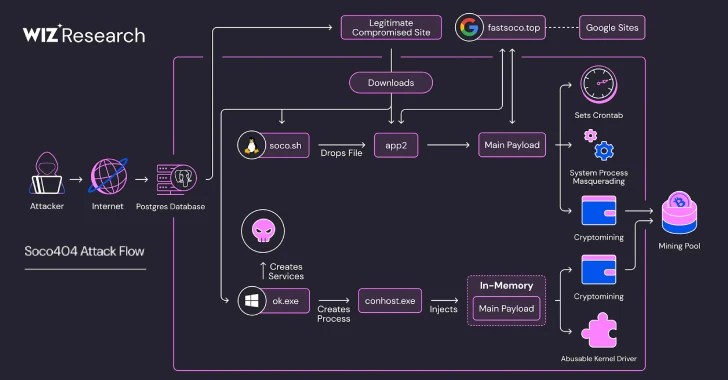

اكتشف الباحثون أنه يمكن إخفاء التعليمات الضارة باستخدام تقنيات التشفير مثل Base16، وUnicode smuggling، مما يجعل اكتشافها أكثر صعوبة. عدم وجود معالجة صحيحة للمدخلات أدى إلى هذه الثغرة في GitLab، حيث يمكن للمهاجم زرع تعليمات في الموقع.

يسلط هذا الهجوم الضوء على الجانب المزدوج لمساعدي الذكاء الاصطناعي مثل GitLab Duo: عندما يتم دمجهم بشكل عميق في سير العمل التطويري، فإنهم يرثون ليس فقط السياق، ولكن المخاطر أيضًا. وقد كشفت مجموعة من الباحثين من جامعة برينستون عن تأثر أنظمة أخرى مثل ElizaOS، وهو إطار عمل لعمليات Web3، بهذه النوعية من الهجمات.

الخاتمة والتساؤلات

تطرح هذه الثغرات تساؤلات حول مدى اعتمادنا على أنظمة الذكاء الاصطناعي في العمليات الحساسة. كيف يمكننا تعزيز أمان هذه الأنظمة وتقليل المخاطر المرتبطة بها؟ شاركوا آرائكم وتعليقاتكم على تويتر وفيسبوك.

شاركنا رأيك بتعليق